Hi Steemianer,

Lungenkrebs (Bronchialkarzinom) ist bei Männern die häufigste zum Tode führende Krebserkrankung (1). Zu 85% ist er auf das Rauchen zurückzuführen. Die unterschiedlichen Subtypen und Stadien sind bislang nur histologisch (an Gewebeproben) zu unterscheiden, durch zeitlich aufwendige visuelle Inspektion von erfahrenen Pathologen.

In Nature Medicine wurde kürzlich eine interessante Studie publiziert (2), bei der Wissenschaftler der New York University (NYU) rund um Dr. Aristotelis Tsirigos Inception v3, einen Open-Source Deep-Learning-Algorithmus (von Google entwickelt und als open-source zur Verfügung gestellt) darauf trainiert haben, zwei der häufigsten Arten von Lungenkrebs zu unterscheiden. Dieser Lernalgorithmus, ein "convolutional" neurales Netzwerk, das die Mustererkennung in Bildern perfektioniert, hatte auch schon gezeigt, dass er frühe Anzeichen von diabetischer Retinopathie in Retinabildern genauso gut erkennte konnte wie menschlichen Experten (3). Mehr Infos über "convolutional" neurale Netze hier (4).

Dazu speisten die Forscher hunderttausende Bilder aus einer öffentlichen Datenbank mit dem Namen The Cancer Genome Atlas (TCGA) ein, um dem Algorithmus beizubringen, Bilder von erkranktem und gesundem Gewebe zu unterscheiden (5).

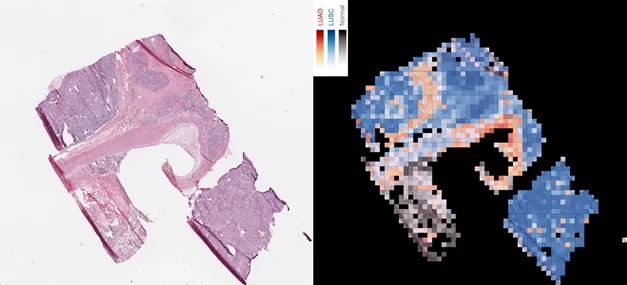

Sobald Inception gelernt hatte, Krebszellen mit einer Genauigkeit von 99% zu erkennen, war der nächste Schritt, der AI beizubringen, Adenokarzinom von Plattenepithelkarzinom zu unterscheiden, die die häufigsten Lungenkrebssubtypen sind. Unter dem Mikroskop sehen sie fast gleich aus, dabei müssen sie aber sehr unterschiedlich therapiert werden. Das schaffte das AI-Programm in 97% der Fälle. In der Hälfte der restlichen Fälle (1,5%) klassifizierten auch menschliche Pathologen den Tumortyp falsch, was unterstreicht, wie schwierig die Unterscheidung ist (6). Bemerkenswert, dass 45 der 54 von zumindest einem Pathologen falsch kategorisierten Bilder vom Algorithmus korrekt zugeordnet wurden.

Links die Gewebeprobe, rechts die Einschätzung der AI (Adenokarzinom rot, Plattenepithelkarzinom blau) Quelle

Doch das neuronale Netzwerk der NYU lernte nicht nur das, sondern noch mehr - etwas, was bisher keinem Pathologen gelungen ist: nicht nur den Krebstyp, sondern auch dahinterliegenden genetischen Mutationen, die in jedem Tumor vorzufinden sind, zu identifizieren. Konkret konnte die AI vorhersagen, ob von 6 Genen, die alle mit Bronchialkarzinom assoziiert sind (unter anderem EGFR, KRAS, and TP53) abnormale Kopien vorlagen, mit einer Genauigkeit von 73-86%.

Das neuronale Netzwerk hatte gelernt, extrem feine Veränderungen am Aussehen einer Tumorprobe zu bemerken, die Pathologen nicht sehen können.

Ob ein Tumor EGFR-induziert ist oder nicht, hat eine relevante Auswirkung auf die Therapie, da es bereits gezielte Medikamente dafür gibt, die aber bei anderen schadhaften Genen nicht wirken würden. Die genetischen Tests dauern derzeit noch einige Wochen, eine sofortige Bestimmung durch eine AI-Bilddiagnose würde dem Patienten daher Wochen an Zeitgewinn im Kampf gegen den Krebs bringen!

Das Black-Box-Problem von Deep Learning Algorithmen

Was diese subtilen Veränderungen jedoch sind, wissen die Forscher nicht. Sie liegen irgendwo in den Tiefen des Algorithmus und niemand weiß, wie man sie herausholt - das Black-Box-Problem von Deep Learning. Es ist besonders dringlich in der Medizin. Kritiker meinen, dass Algorithmen erst besser verstanden werden müssen, bevor sie großflächig zum Einsatz kommen. Aber Leute wie Olivier Elemento, der Direktor des Instituts für Präzisionsmedizin an der Cornell Universität, finden, es wäre geradezu fahrlässig, ein Verfahren, das in 99% der Fälle die richtigen Antworten liefert, nicht in einem klinischen Test anzuwenden – auch wenn man nicht wisse, wie es funktioniert (5).

„Damit ein solcher Algorithmus eingesetzt werden kann, muss er nicht vollständig entschlüsselt sein. Er muss nur zuverlässig sein“, sagt Elemento.

Eine perfekte Zuverlässigkeit zu erreichen ist aber nicht einfach, da verschiedene Krankenhäuser ihre Tumorproben mit unterschiedlichen Instrumenten und Verfahren behandeln und auch weil Krankenhausproben viel mehr Störeinflüsse wie Entzündungen, abgestorbenes Gewebe etc. aufweisen. In der Tat ging die Genauigkeit der AI etwas zurück, von 97% bis auf 83%, wenn statt der Atlasbilder echte Proben von Krebspatienten der NYU getestet wurden. Dem Algorithmus beizubringen, mit all diesen Variationen umzugehen und so die Treffgenauigkeit zu optimieren, ist das, was Tsirigos und sein Team gerade tun. Sie trainieren das AI-Programm mit noch mehr Daten aus verschiedensten Quellen. Ultimatives Ziel: Man sendet einfach das digitale Foto einer Tumorprobe und erhält fast sofort eine Diagnose mit geeigneten Behandlungsmöglichkeiten. Ab einer Genauigkeit von über 90% wollen sie um FDA (US-Arzneimittelbehörde)-Erlaubnis ansuchen, dieses AI-Tool auch im klinischen Alltag einsetzen zu können.

„Die große Frage ist, ob die Sache vertrauenswürdig genug ist, um die derzeitige Vorgehensweise zu ersetzen", sagt Daniel Rubin, Direktor für biomedizinische Informatik am Stanford Cancer Institute. Es deutet jedenfalls alles auf eine Zukunft hin, in der menschliche Pathologen mit Computern zusammenarbeiten.

Die Rolle der Ärzte in der Zukunft

Dadurch ergibt sich die Frage, was die Aufgabe der Pathologen langfristig sein wird, wenn die Rolle der AIs sich einmal etabliert hat. Da Google und andere Unternehmen ihre Algorithmen als Open-Source-Code zur Verfügung stellen, können Forscher nun relativ einfach ihre eigenen AI-Projekte starten. Mit nur ein wenig Anpassungsarbeit sind die neuronalen Netze bereit, auf einen Berg von biomedizinischen Bilddaten losgelassen zu werden, um eventuell ebenso überraschende Einsichten zu gewinnen. Denn eines scheint klar, dass auf den Bildern viel mehr Informationen zu sehen sind, als Menschen darauf erkennen können.

Die Ärzte hätten keine Angst davor, ersetzt zu werden, sagt Tsirigos nach seinen Erfahrungen. Sie seien „begeistert, dann selbst tiefer gehende Fragen stellen zu können, weil sich die Maschine um die einfachen kümmert“. Nach dem Motto: Überlasst die Objekterkennung den Maschinen, es ist noch viel Medizin für den Menschen übrig. So einfach sehe ich es nicht, denn es zeigte sich ja, dass die AIs in mancher Hinsicht den Menschen überlegen sind.

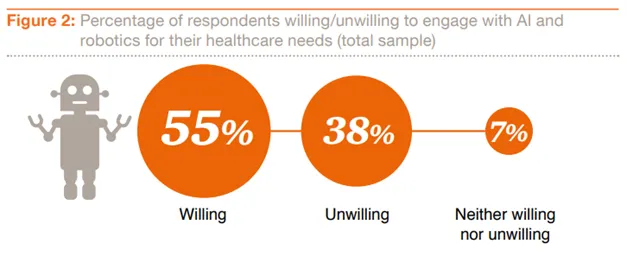

Ob die Patienten für AI-Konsultationen oder AI-gestützte Operationen bereit sind, ist eine andere Frage. Zumindest ergab sich aus einer 2017 von PWC herausgegebenen internationalen Online-Umfrage schon eine teilweise große Bereitschaft dazu (7). Es waren aber große Unterschiede je nach der Versorgungslage der Menschen zu beobachten. So wären in Nigeria wesentlich mehr Menschen als in Europa bereit, mit AIs zu interagieren, da es dort einen extremen Mangel an Ärzten gibt. Die Europäer sind da noch weit skeptischer.

Quelle

Quellen:

(1) http://www.krebsimfokus.at/ueber-krebs/lungenkrebs/im-ueberblick.html

(2) https://www.nature.com/articles/s41591-018-0177-5

(3) https://www.wired.com/2017/06/googles-ai-eye-doctor-gets-ready-go-work-india/

(4) https://medium.com/technologymadeeasy/the-best-explanation-of-convolutional-neural-networks-on-the-internet-fbb8b1ad5df8

(5) https://www.wired.de/article/ki-von-google-erkennt-jetzt-sogar-mutationen-von-tumoren-krebs-forschung

(6) https://medicalxpress.com/news/2018-09-artificial-intelligence-lung-cancer.html

(7) https://www.pwc.at/de/publikationen/branchen-und-wirtschaftsstudien/healthcare-ai-new-health.pdf